最近はノートPCなんかにもGbE(1000Base-T)のLAN環境がありますが、最近の記憶デバイスの高速化で案外足を引っ張ります。

以前はSATA HDDなんかだと100MB/s位だったので、GbEでちょうど良いバランスだったのですが、最近のSSDでは500MB/s超もざらだし、我が家だとSATA HDD x 8のRAID5/6なんかは600MB/s位出るのでLAN経由でコピーしたりするとなかなかアンバランスになる。

400MB/s位までならGbEを4本束ねることで対応することも出来るけど、オンボードのNICは2本が相場だからDualかQuadのNICを挿さないとダメだし配線も増える。 結果的に、10Gbのホスト間接続を用意するのが良さそうだ。

いつものサーバ屋で未検証のInfiniBandアダプタ(SDR)が安売りしていたため、これを2本購入して来た。

InfiniBandはHPCのインターコネクトで使われる高速インタフェイスで、今回のボードはSFF8470(CX4)端子がデュアル搭載の物なので、当初はストレージサーバ2台間を直結しておいて、InfiniBandファブリックの環境が出来たら残りの1ポートをファブリックに繋いでやりたいところ。

しかし、銅ケーブルは上限が10m台の上に太くて硬いので家の中で使うにも配線困難となるため、実質、ラック内のサーバ間コネクトとしてファイルサーバとバックアップサーバを常設接続して、ドライブバックアップ用の端末をオンデマンド起動してバックアップサーバとコネクトする程度になるだろう。

ケーブル自体はSASのSFF8470ケーブルがコンパチなので、以前のテープライブラリ接続に使っていた3ftケーブルで接続実施。

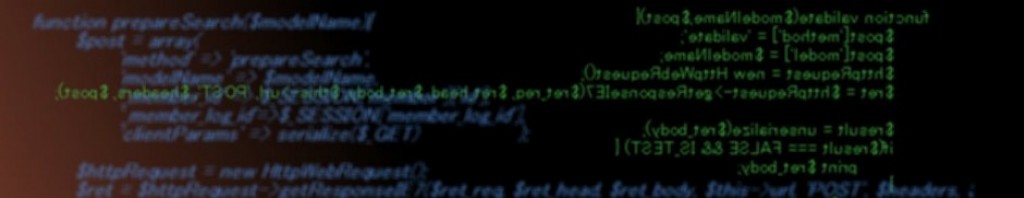

Windows2012R2サーバに挿すとそのまま認識したので、後はOpenSMを導入してやるとLANのプロパティが8.0Gbps表示になった(InfiniBandはワイヤーの帯域に対して実データが10:8の為)

IPをバインド(IPoIB)してファイル転送してみるとSSD=SSDのファイルコピーがLAN経由なのに470MB/sとか出て、SATA直結と大差ない高速性を発揮。 この辺は、さすがハイエンド向けのインタフェイスだけ有る。

現在はInfiniBandもより高速な40Gとかに主戦場が移っているので、10Gは型落ちとして市場に出始めているので、2PC間で高速データ転送を実現したいなら、この辺の中古機材を乗せるのもアリな選択だろう。

一般的なLANメディアのツイストペアケーブル利用の10GbE規格である10GBase-T対応NICは最近では4万円あたりまで降りてきているのと、対応スイッチも10万円台にいるので、もう少しボリュームが膨らめば新品で構築も出来るようになるだろうが、現状では少ない台数ならCX4直結が一番安い方法だろう。

※表記が10Gbと10GbEに揺れているのは、GbEのEはEthernetだが、InfiniBandはEthernetと同じレイヤーの規格なので10GbIB(2.5Gb 4レーンIB)となる為

(239)